文系学部生というデータサイエンスの王道からはやや外れた立場から,「データ分析を仕事にする(総合職ではなく職種別採用で働く)」という軸で就職活動をするなかで見かけた業界についてメモします。

文系出身だと就職先が絞られ(とくに大手企業),業界の探し方に関して苦労した経験*1があるため,今回はデータサイエンティスト・アナリストを採用していて,「文系お断り」な雰囲気はなさそうだった業界について述べます。

まず,ビジネスにおけるデータ分析の使われ方を確認し,その次に具体的な「データ分析を使う業界」について述べていくという構成になっています。

ビジネスにおけるデータ分析の使われ方

データ分析のレベル

「データ分析」といってもレベルは様々です。「我が社ではデータ分析の業務ができます!データサイエンティストになりたい学生募集中!」みたいな企業があったとしても,話を聞いてみると集計して表やグラフを作り,解釈する業務だったり…なんてこともありました。

まずビジネスでのデータ分析の種類を把握する必要があります。

有名どころの「データ分析のレベル」の分類方法では,以下のような分け方をしているようです。

1. Descriptive Analytics(記述的分析)

データから,「何が起きたのか」を明らかにする。

グラフや表で可視化する,データを解釈するストーリーを考えるなど。

2. Diagnostic Analytics(診断的分析)

データから,「なぜ起きたのか」を明らかにする。相関関係を調べるなどして,より深く調べていく。

3. Predictive Analytics(予測的分析)

確率的な予測を行うモデルを構築する。

4. Prescriptive Analytics(処方的分析)

データから,「何をすべきか」を明らかにする。予測されたモデルから最適な方策を立案する。

例えばレコメンデーションシステムのように,予測結果から提案を最適化するようなもの。

とりわけ,「記述的・診断的な分析」をするレベルなのか,それともより高度に「予測的・処方的な分析」をするレベルなのかが業務の性質を大きく変えると思います。

就職活動の会社探し・業界探しの観点で言うと,私は就職活動を初めた頃にマーケティングリサーチ最大手の株式会社インテージを知り,そこのデータアナリストはマーケティングの分析だけでなく広告予算配分の最適化という「予測的・処方的な分析」も行っているようで,マーケティングリサーチ業界に興味を持つようになりました。

その後もマーケティングリサーチ業界を見ていたのですが,次第にミスマッチを感じるようになりました。というのもマーケティングの場合は予測して自動化とかよりも原因を診断するほうが重要なので,多くのマーケティングリサーチの企業のデータアナリスト職の仕事は「記述的・診断的な分析」がほとんどで,たまに回帰分析や決定木を使うとしても診断的分析の目的で使用しているようでした。

就職活動のときには,自分がやりたい「データ分析」とは「記述的・診断的な分析」なのか「予測的・処方的な分析」なのかを明らかにし,企業を探す時にはその企業の言う「データ分析」がどのレベルなのかを調べる必要があります。

統計学と機械学習

すごくざっくりいうと,「予測」をする際には統計学的な手法(e.g. 線形回帰)よりも機械学習(e.g. GBDT, DeepLearning)の方が精度が良いことが多いです。 なので,「予測的・処方的な分析」をする場合は機械学習がほぼ必須になるかと思われます。

なんとなく「大学で学んだ統計学を使う仕事に就きたい(機械学習は興味ない)」と思っている方は仕事内容がどういうジャンルなのか注意が必要かなと思います。 (統計学の基礎知識があれば機械学習を独習することは可能なので,「今は統計学しか知らないけど機械学習を使う仕事がしたい」というスタンスはOKだと思います)

データ分析の職種

データ分析系の職種は主に以下の3種類があるかなと思います。

1. データアナリスト

- 「記述的・診断的な分析」が主業務である企業が多い印象(仕事のアウトプットはレポート)

- 必要なスキル:統計学+ビジネス力(経営学・マーケティング論,プレゼンなど)

- 分析はR,SPSS,SAS,その他ツールを使う。プログラミングが必須でない企業も多い印象。

2. データサイエンティスト

- 「記述的・診断的な分析」と「予測的・処方的な分析」の双方を行う(仕事のアウトプットはレポート)

- 必要なスキル:統計学+ビジネス力+機械学習+プログラミング(分析)

- R,Pythonなどのプログラミングの能力が必要な企業が多い印象

3. 機械学習エンジニア

- 「予測的・処方的な分析」を自動化するシステムを作る職(仕事のアウトプットはシステム)

- 必要なスキル:統計学+機械学習+プログラミング(分析)+ プログラミング(システム開発)

- 深層学習の論文に登場する数式をプログラミングして実装できる能力が必要とされることも

※この解説は私の個人的な印象に基づきます。誤りがあるかも‥

※職種の定義は企業によって結構異なります。

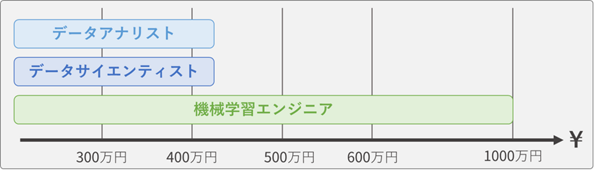

ちなみに,これらの3職種の新卒1年目の年収は,

- データアナリストとデータサイエンティストは同程度(~420万円)

- 一般的な総合職と比べても,そこまで高いわけでもない

- 機械学習エンジニアは上限が高い(~1,000万円)

という感じです。

企業の例としては以下のような感じ。機械学習エンジニアが最も市場から求められている感じがします。

しかし,文系学部卒ではこれらの高給な機械学習エンジニアになるのは難しいと思います。

ソフトウェア開発(Java等)ができることが必要であったり,機械学習についての高い専門性を要求する企業もあります。

大学の専攻と関係なく趣味でソフトウェア開発をしているような人であれば良いですが‥

データ分析の職種別採用がある業界

「データ分析人材を必要としていて積極的に雇用しようとしている企業はどこなのか」という点は就活中にとても悩まされました。なのでここでは会社選びのヒントとなるようにデータ分析を使う業界について述べていきます。

以下の図は,私がデータ分析職の職種別採用を行っているのを見かけた企業の業界を,事業の「コンサル / 事業会社」,業務内容の「アナリスト寄り / エンジニア寄り」の2軸で散布したものです(業界というか部門もありますが…)。

なお,「コンサル / 事業会社」という軸を設けたのは,それぞれ一長一短あり重要な軸であるためです。

現在私は以下のようなメリット・デメリットがあるのではないかと想像しています。

より具体的な例として,私が就活中に出会った業界を以下に述べていきます。

マーケティングリサーチ(市場調査)業界

業界の概要

この業界の企業の例

デジタルマーケティング業界

業界の概要

事例

この業界の企業の例

総合コンサルティングファーム

業界の概要

事例

この業界の企業の例

データ分析コンサルティング

業界の概要

- データ分析による課題解決を請け負う

- 「記述的・診断的な分析」と「予測的・処方的な分析」の双方を行う

事例

- 深層学習による画像解析を用いた,工場における不良品検知

- 状態空間モデルを用いた商品の需要予測

この業界の企業の例

- 株式会社ブレインパッド

- 2004年創業。この業界では古参で最大手。

- 売上高35億円,216名:社員一人あたり1600万円の売上高,平均年収640万円(34.1歳)

- 株式会社ALBERT

- 売上高8.7億円,88名:社員一人あたり約1000万円の売上高,平均年収655万円(33.7歳)

- 技術はありそうだが稼ぐ力は微妙?。営業キャッシュフローもマイナスが目立つ

- 株式会社ホットリンク:SNS,ネット掲示板データの分析に強み。平均年収595万円(35.1歳)

- 株式会社ダブルスタンダード:売上高14億円,平均年収527万円(35.6歳)

- データセクション:売上高6億円,平均年収337万円(30.5歳)

- スカイディスク:製造業の工場に対するデータ分析コンサルに特化したベンチャー

- 株式会社ブレインパッド

システムインテグレーター(SIer)

業界の概要

- クライアント企業に対してIT面でのコンサルティングを行なう業界

- データ分析がやりたい人にとってのデメリットとしては,分析だけでなくエンジニアの仕事もしなければいけない企業も多いこと

- 「予測的・処方的な分析」を行う

この業界の企業の例

- ソフトバンク・テクノロジー(データサイエンティスト職での採用がある)

事業会社のマーケティング部門

業界の概要

事例・企業の例

- 本田技研工業(ホンダ),ビジネス開発統括部ビジネスアナリティクス課

- 事例①:車のデザインの評価:SNSでの評価を感情分析し,新しいデザインがどう評価されるかを予測

- 事例②:乗り心地の評価:車に乗っている人の脳波などの生体反応データと車の速度などのデータの関係から,クルマの状態によって乗っている人の感情がどう変化するかを分析

- (参考:クルマのデザインや乗り心地……「感性」も科学的に評価するホンダの取り組み - 日経BigData http://business.nikkeibp.co.jp/atclbdt/15/258684/041900073/)

- 本田技研工業(ホンダ),ビジネス開発統括部ビジネスアナリティクス課

事業会社のデータ分析部門

業界の概要

- マーケティングだけでなく新規事業の提案も含めて様々な部分にデータ分析を活用する仕事

- 「記述的・診断的な分析」と「予測的・処方的な分析」の双方を行う

事例

この業界の企業の例

アドテクノロジー業界

業界の概要

- 広告配信の最適化に統計学などのデータ分析を活用する

- デジタル広告は「どんな人に送った結果,どれだけ効果がでた」という情報がわかり効率が良いため,市場は拡大傾向(広告市場自体は縮小しているものの,デジタル広告の比率は増加)

- 「予測的・処方的な分析」を行う

事例

- 広告の買い付けシステム

- ユーザーがWebサイト等を閲覧して広告枠を表示するときに,背後では広告枠のオークションが行われている。

- 広告の枠のオークションが始まった時,「広告の種類」「広告の枠」「ユーザーの属性」といったデータから,広告のCTR(クリック率)やROI(費用対効果)を予測し,「何円で買う」とオークションに参加する

→ 広告を出した結果,どれだけクリックされ,どれだけ買ってもらえたかがわかる

→ そのデータをもとに,より良いCTR予測モデルを構築する - このシステムは瞬時に行われる広告枠の売買で使われる関係上,計算がすぐに終わるロジスティック回帰を使う事が多い

- 広告の買い付けシステム

この業界の企業の例

- ユナイテッド株式会社(データサイエンティスト採用がある)

事業会社のシステム開発部門・研究開発部門

業界の概要

事例

この業界の企業の例

参考

データ分析のレベルに関しての参考文献です

アナリティクスの進化(Descriptive からPrescriptiveへ) | 欧州進出のIT支援はNewton IT

私が就活で体感した情報ばかりなので全く網羅的ではないと思いますが,データ分析を仕事にしたいと考えている就活生のお役に立つことがあれば幸いです。

*1:例えば自動車メーカーは自動運転の関係もありAI人材のニーズを持っているものの,「文系お断り」状態だった。